传感器数据和融合

-

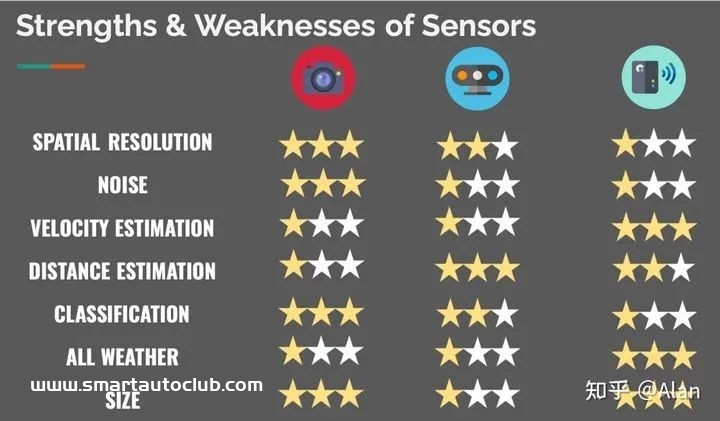

摄像头擅长处理对象分类及理解场景。 -

作为一种飞行时间传感器,激光雷达非常适合估计距离。 -

雷达可以直接测量障碍物的速度。

摄像头:2d传感器

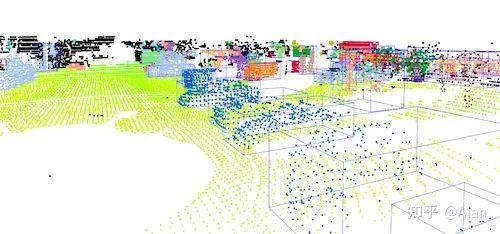

激光雷达:3d传感器

传感器融合算法

-

按抽象级别:“何时”进行融合?when -

按中心化级别:在“哪里”进行融合?where -

按竞争级别:融合“什么”?what

-

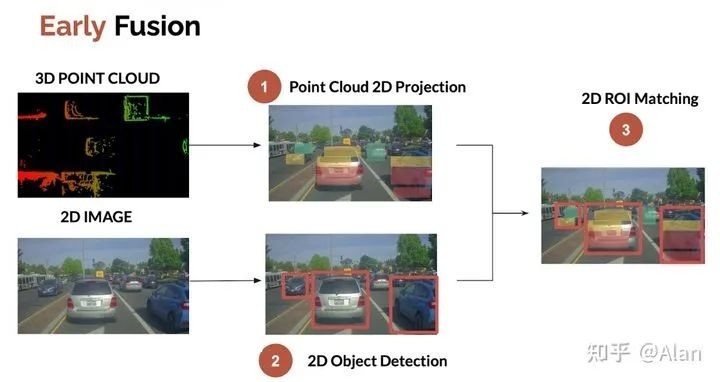

早期融合:融合原始数据--像素和点云。 -

后期融合:融合结果--来自激光雷达和相机的边界框。

早期传感器融合:融合原始数据

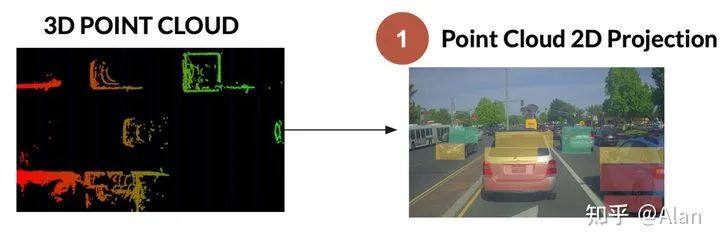

1.点云投影到2D

-

将每个3D激光雷达点转换为齐次坐标。

输出:激光雷达帧/齐次坐标 -

应用该转换点的投影方程(平移和旋转)将该点从激光雷达帧转换为相机帧。

输出:相机帧/齐次坐标 -

最后,将点转换回欧几里得坐标。

输出:相机帧/欧几里得坐标

2.2D对象检测

3.ROI匹配

-

对于每个边界框,相机给出分类结果。 -

对于每个激光雷达投影点,都有一个非常准确的距离。

-

每个点的平均值? -

中位数? -

中心点? -

最近的?

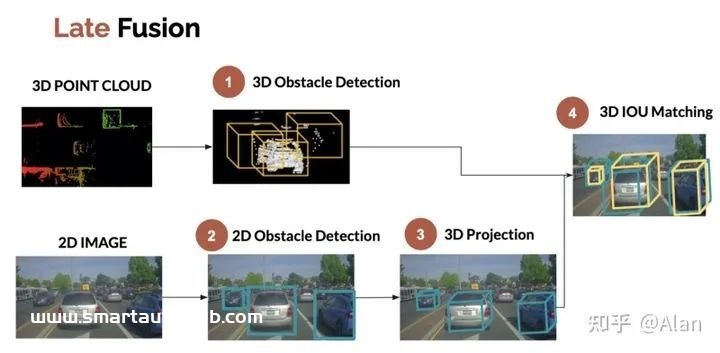

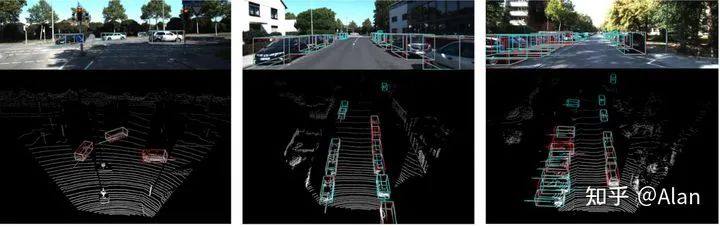

后期传感器融合:融合结果

1.3D障碍物检测(激光雷达)

-

朴素的方法,使用无监督的3D机器学习。 -

深度学习方法,使用RANDLA-NET等算法。

2.3D障碍物检测(相机)

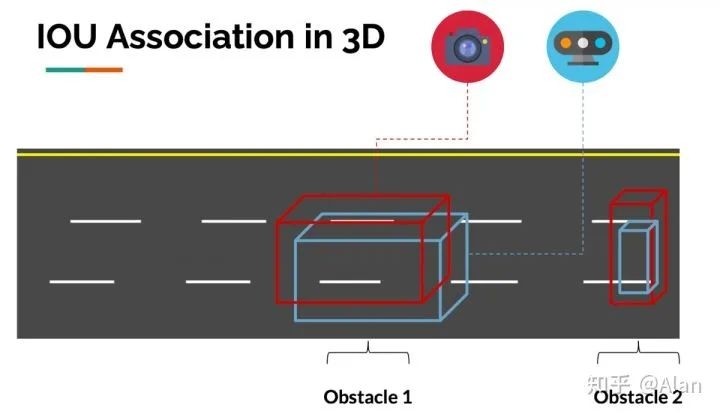

3.IOU匹配

空间中的IOU匹配

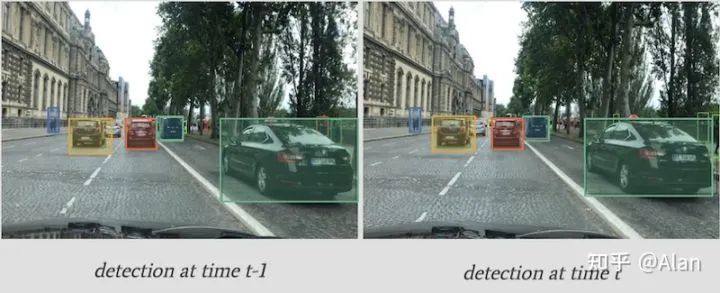

时间上的IOU匹配

总结

The original text was originally published on WeChat public account (Automotive Electronics and Software):自动驾驶汽车中的激光雷达和摄像头传感器融合

Welcome to join us.Aibang lidar industry communicationThere are currently 2,700 people, including relevant persons in charge from major lidar manufacturers and OEMs. Click on the tags below to filter

Lidar OEM Autonomous Driving application terminal laser VCSEL light detector sensor Optical element Optical module filter Galvanometer Optical components radome cover adhesive Electronic component semiconductor chip tier1 Parts Non-standard automation Hardware circuit board motor Coating Coating equipment Plastic Products vehicle electronics Surface treatment auto parts equipment Testing Equipment Connector plastic Material software trading acting College graduate School other

Download:

Download: