摄像头在智能汽车时代被誉为“汽车之眼”,如果没有记错的话是Mobileye开创了智能汽车基于AI底层的摄像头的应用,而马斯克的特斯拉彻底把他发扬光大了,这下汽车产业一发不可收拾的开启了基于AI的摄像头的竞赛。

上篇文章《深入了解当前主流L2的ADAS 模块(零件以及供应链)》了解到智能汽车市场的摄像头市场巨大,那么智能汽车单车到底要用多少个呢?他们分别用在哪方面呢?智能汽车摄像头技术和难点在哪里?

-

智能汽车单车到底要用多少个摄像头? -

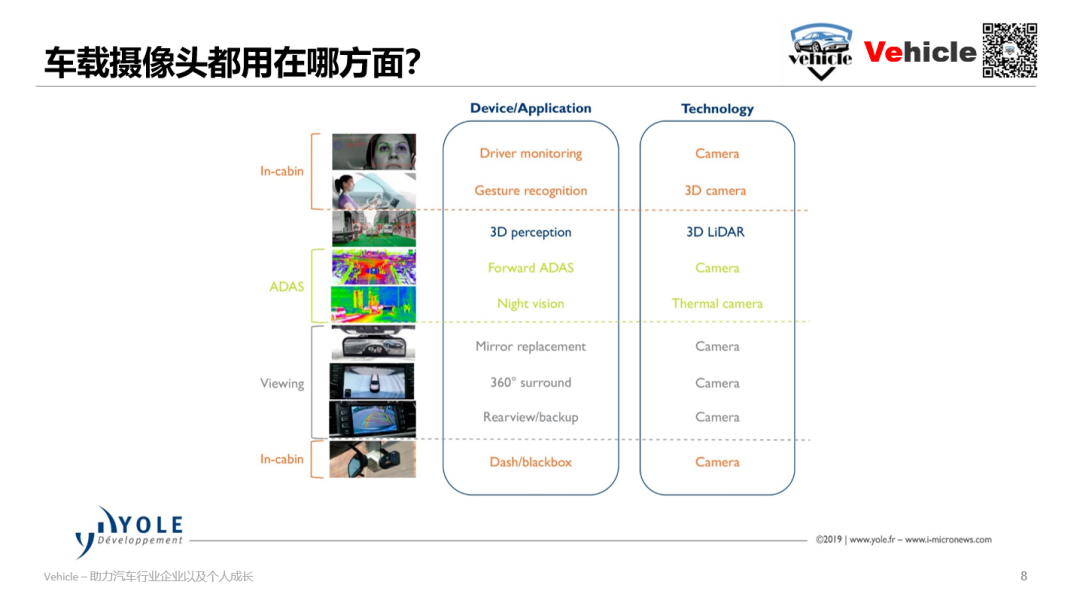

智能汽车摄像头分别用在哪方面呢? -

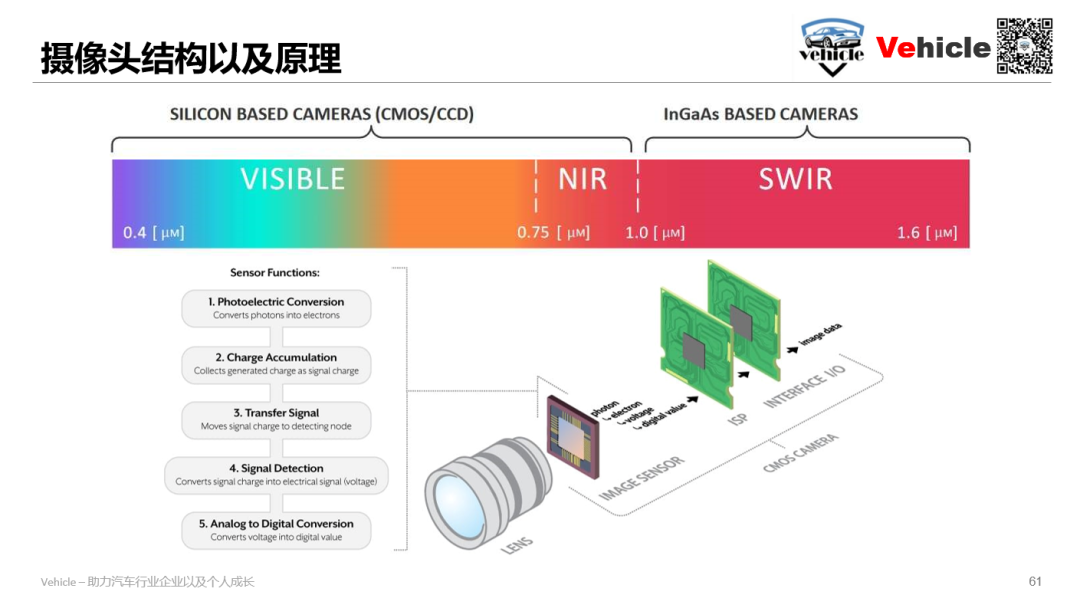

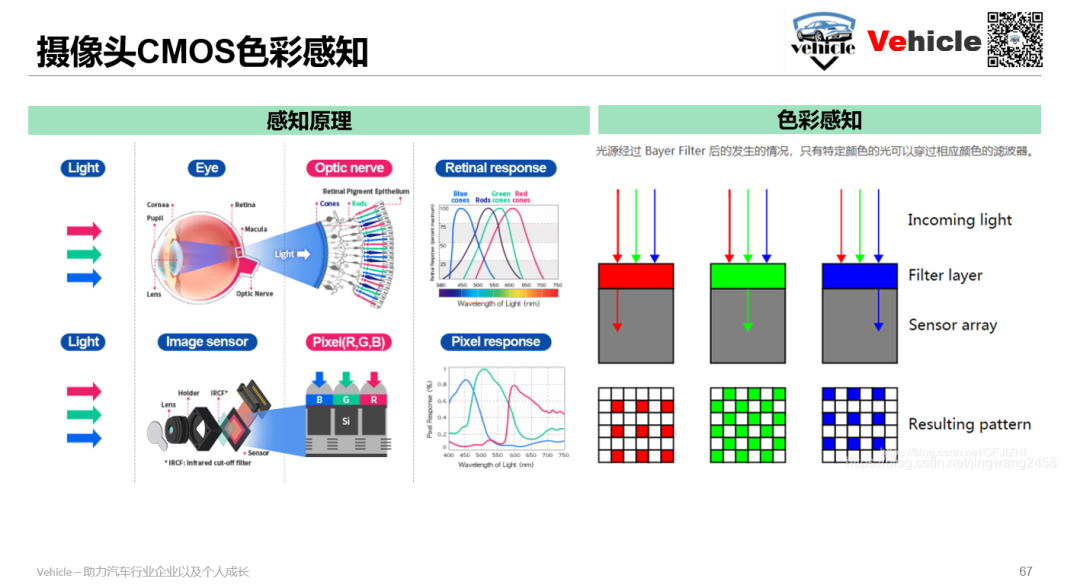

智能汽车摄像头技术原理是什么? -

智能汽车摄像头应用的难点在哪里?

-

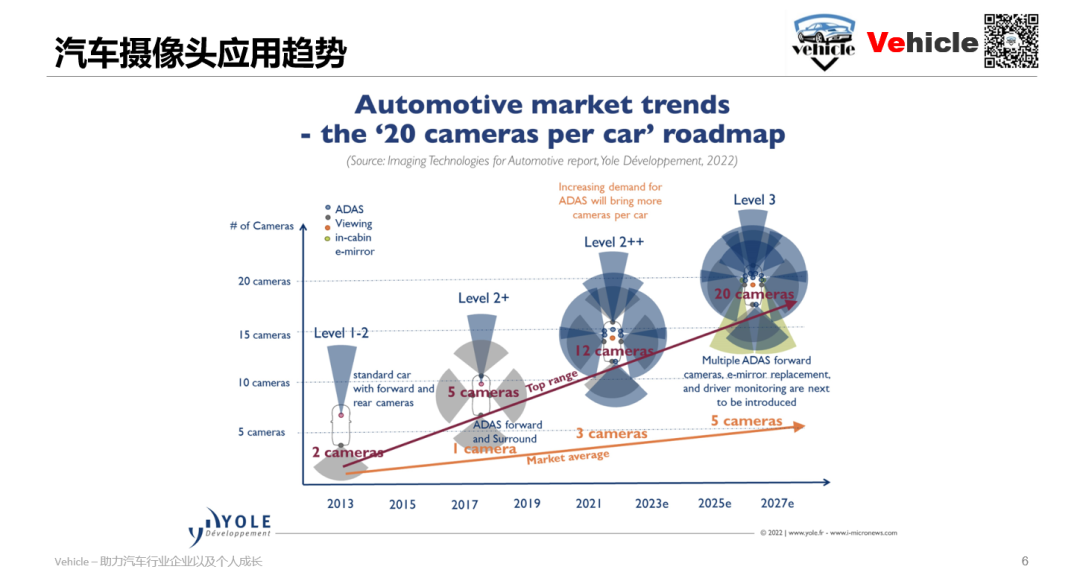

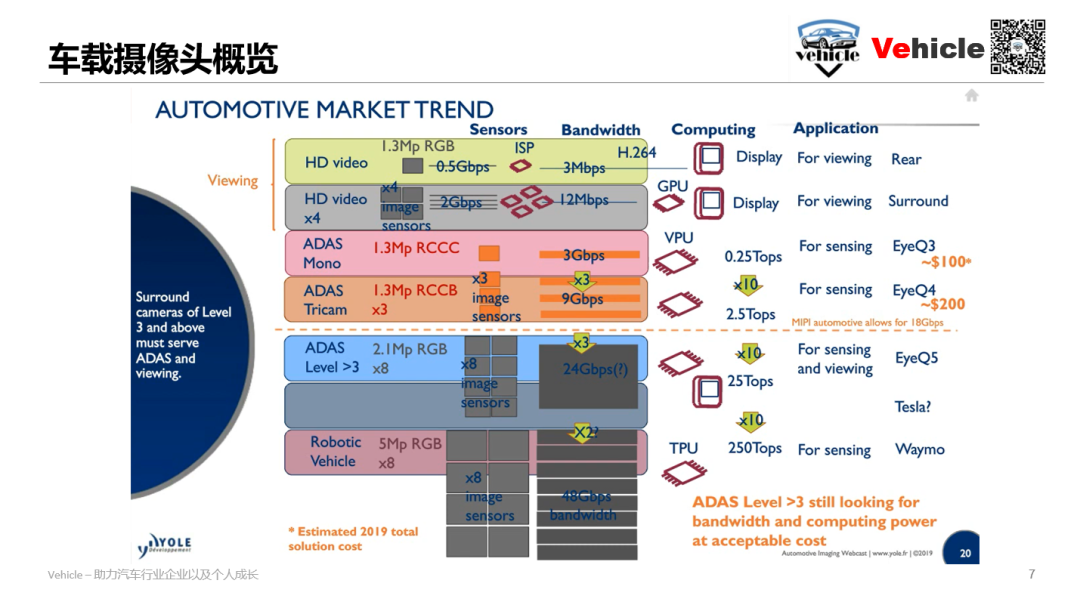

在L1-2阶段摄像头大概1-2个。 -

到了L2阶段摄像头大概是1-5个。 -

到了L2++阶段也就是现在摄像头大概3-12个。 -

到了L3阶段大概5-20个。

-

像素(megaPixels):像素可以决定看的多远多大,但对于AI 那么处理器需要信息越多。 -

帧数(fps),每秒获取画幅,这个汽车上体现的就是例如碰撞时间。 -

Dynamic range:测量了图像传感器在同一张照片中同时捕获光明和黑暗物体的能力也即动态范围越大,保留的高光区和阴影区信息越多。

-

RGGB也常缩写成RGB,RGB是三原色,世间万物的色彩鼻祖,所以这种摄像头是生活常用的,也是视觉呈现常用的。例如360环视。 -

RCCC 最大限度提高光灵敏度,保留红色例如红绿灯和尾灯。RCCC 图像看起来是单色的,无法记录彩色图像。三个透明滤光片为其提供最佳灵敏度,而红色滤光片元件可识别来自刹车或交通信号灯的红光。所以当前大部分ADAS前置摄像头采用这个方案包括特斯拉HW2.0。 -

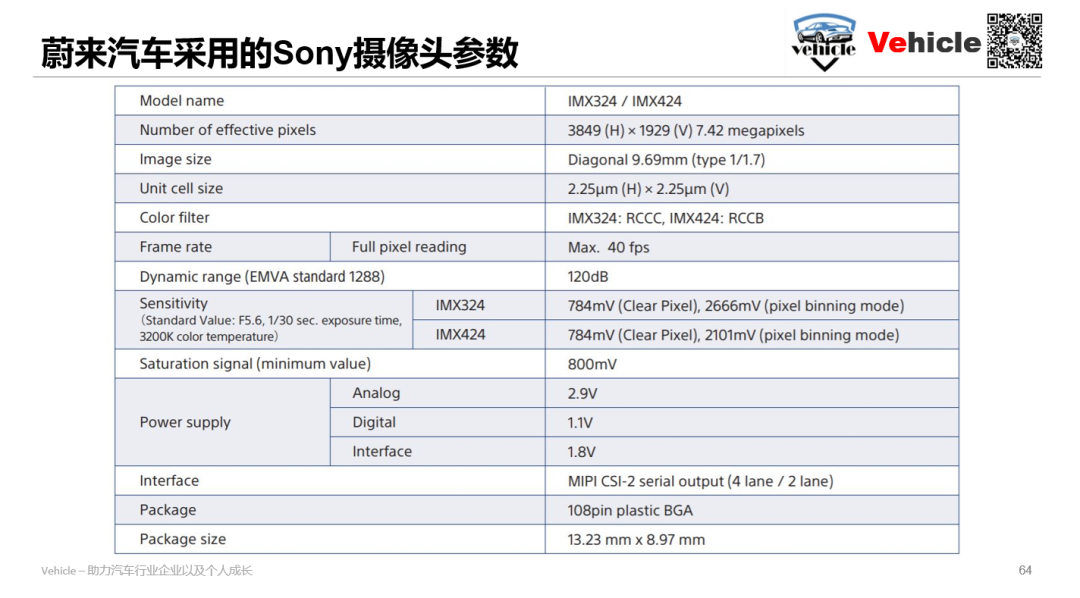

RCCB 提高了光灵敏度和更少的噪点,带有一个红色滤光片、两个透明滤光片和一个蓝色滤光片(见图 2c)。但它分辨色彩的能力更好,采集的图像既可以用于机器分析,也可以用于人眼观察。所以当前不少采用RCCB既保证光灵敏也保障了视觉屏幕输出的需求,例如特斯拉的HW2.5之后的摄像头以及蔚来ET5,ET7(了解点击2021 NIO Day -你想知道的(ET5,以及自动驾驶,智能座舱))采用的索尼摄像头IMX424。

-

当前特斯拉的自动驾驶天花板在感知传感器摄像头方面,再牛逼的算法也无力回天毕竟你对环境感知缺少三原色中的一种。当然有人透露tesla下一代摄像头将采用SONY 5mp的RGGB摄像头。

-

蔚来汽车最新的Aquila摄像头方案不经济而且精确比不了同样采用激光雷达加RGB摄像头。

-

Paving the way to self-driving cars with advanced driver assistance systems - TI -

ADAS High Bandwidth Imaging Implementation Strategies - TI -

Advanced Driver Assistance (ADAS) Solutions Guide - TI -

The Fundamentals of Camera and Image Sensor Technology - Jon Chouinard -

Computer Vision in Automated Parking Systems: Design, Implementation and Challenges - Markus Heimbergera , Jonathan Horganb , Ciaran Hughesb , John McDonaldb , Senthil Yogamanib,∗ -

Seeing Through Fog Without Seeing Fog: Deep Multimodal Sensor Fusion in Unseen Adverse Weather - Mario Bijelic1,3 Tobias Gruber1,3 Fahim Mannan2 Florian Kraus1,3 Werner Ritter1 Klaus Dietmayer3 Felix Heide2,4 1Mercedes-Benz AG 2Algolux 3Ulm University 4Princeton University -

Sensor and Sensor Fusion Technology in Autonomous Vehicles: A Review -De Jong Yeong 1,2,3,* , Gustavo Velasco-Hernandez 1,2,3 , John Barry 1,2,3 and Joseph Walsh 1,2,3 -

On the Performance of One-Stage and Two-Stage Object Detectors in Autonomous Vehicles Using Camera Data - Manuel Carranza-García * , Jesús Torres-Mateo , Pedro Lara-Benítez and Jorge García-Gutiérrez -

ADAS: Key Trends on ‘Perception’ - Junko yoshida -

Challenges of full autonomy for sensing in autonomous vehicles - jeff hecht -

Yole 图片整理 - yole -

CMOS图像传感器基础知识和参数理解 - 成都子程电子

*未经准许严禁转载和摘录-获取参考资料方式:

相关推荐

原文始发于微信公众号(Vehicle):智能汽车要用多少个摄像头?分别干啥?什么原理?

OEM Autonomous Driving camera camera Smart Cockpit Radar manufacturer (V2X) Camera module thermal imaging night vision DMS optical lens driving recorder Power IC algorithm chip CMOS Accessories infrared lens Infrared LED Lens processing vehicle electronics Interior and exterior decoration Instrument central control sensor Dispensing glue glue cms filter Glass plastic injection model display circuit board semiconductor Connector Cables and Harnesses film Coating equipment Coating material Heat dissipation material SerDes welding equipment Laser equipment Automation equipment Testing Equipment Mold protective film third party testing 加工 Material acting trading other equipment

Download: