小鹏在自动驾驶方面,赚够了眼球,也赢得了智能汽车的口号,从其小鹏P7对于泊车功能,记忆泊车以及分享停车路线各方面的一些应用创新,到现在P5基本上算市场上真的买得到带激光雷达,而且P5可以升级多层记忆泊车,未来还以升级城市NGP可谓立好了自动驾驶标杆的flage,让人不自觉竖起大拇指。

另外其实特斯拉算是视觉AI主导应用在自动驾驶的主机厂发起者,当然如果深究供应商可能还是mobileye(从2022 CES 看Mobileye 自动驾驶产品技术以及战略(谁说算力是唯一标准))。小鹏算是国内跟进者,小鹏刚出现的时候,特斯拉还就其自动驾驶软件与其有过对簿公堂,所以我相信不少人跟我一样好奇这种视觉主导自动驾驶方案以及小鹏和特斯拉的差异点。

例如

-

小鹏和特斯拉到底有多少个摄像头,为什么小鹏要比特斯拉多四个摄像头?这些摄像头之间的差异是什么?

-

为什么P7挡风玻璃下面四个摄像头,而P5却只有三个了?

-

为啥特斯拉用1.2M的摄像头,摄像头分辨率就是算力的累计

-

小鹏P5的两个激光雷达到底有啥用(同理可以推到G9)?城市NGP?多层记忆泊车?

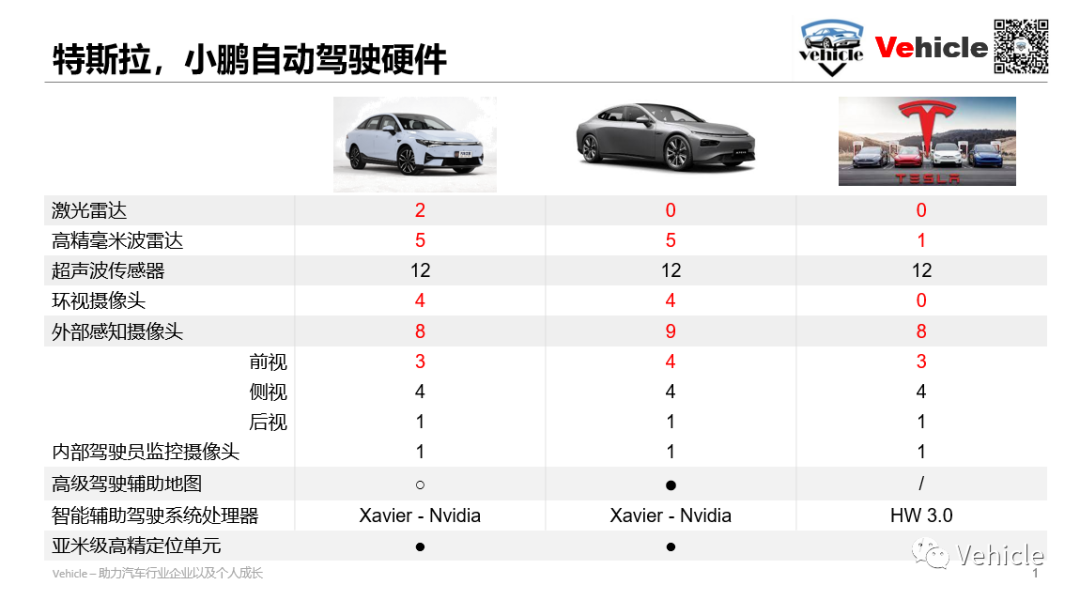

超声波传感器,这是当前最普遍用于泊车的传感器,就是大家一般在前后保看到的圆圈一样的,一般是8-12个,用于泊车检测旁边是否有障碍物,这个当前非常传统,成本也非常低了十几块一个。

millimeter wave radar,这个也是当前比较普遍的,用于ACC巡航前面运动物体探测,另外还有放置在后保险杠两侧做类似盲区检测,后碰撞预警等。

Lidar,这几年中国资金密集投资地方,由于其高精度,受环境影响较小是当前自动驾驶非常热门的一个传感器,具体可以看我们之前文章通过广州车展-看自动驾驶激光雷达了解激光雷达。

camera,其实也是一个非常传统的零部件特别是手机应用特别多,而基于视觉AI的自动驾驶发展,让它在汽车上大放异彩,这也是当前手机和互联网公司相继杀入汽车行业的一个重要原因,毕竟你手机人脸识别,手机的美颜,抖音的变脸合拍。本质上都和自动驾驶使用的算法类似。汽车上当前使用摄像头按照位置以及作用大抵分以下几个。

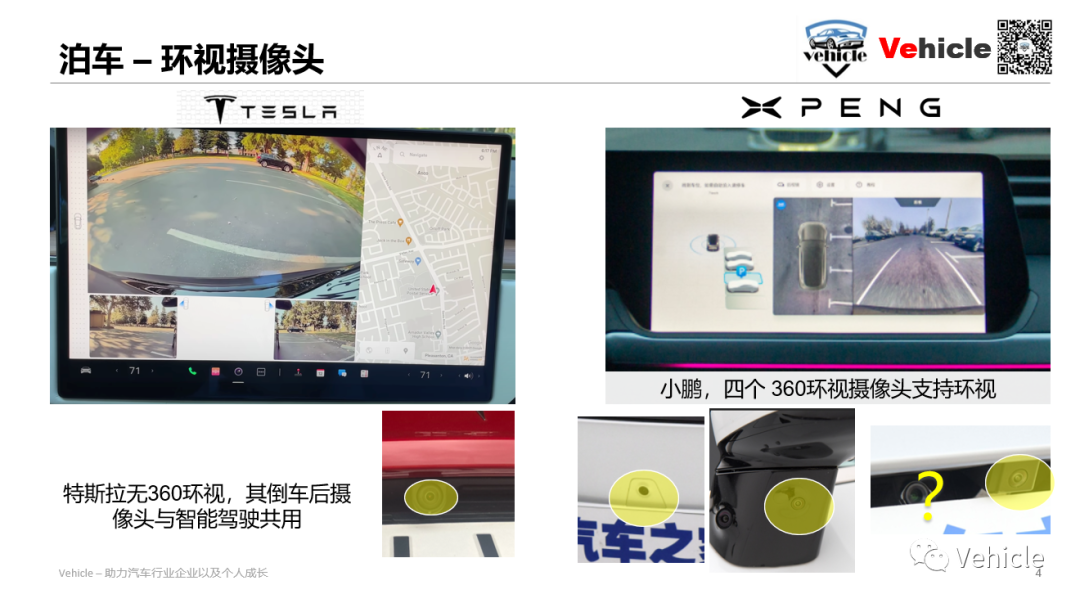

- 环视摄像头,就是整车前后左右四个鱼眼摄像头用来拍摄车辆周边环境的,这个在国内应用特别广360环视,以及基于这个技术搞出来的透明底盘等等,基于环视摄像头的自动泊车在过去几年非常长的火,当前除了外资合资品牌,基本国内主机厂都配备基于环视的自动泊车辅助,因为在老外眼中自动泊车和辅助是鸡肋,我自己来停,第一没有这个使用习惯,第二鲜有这样的使用场景。

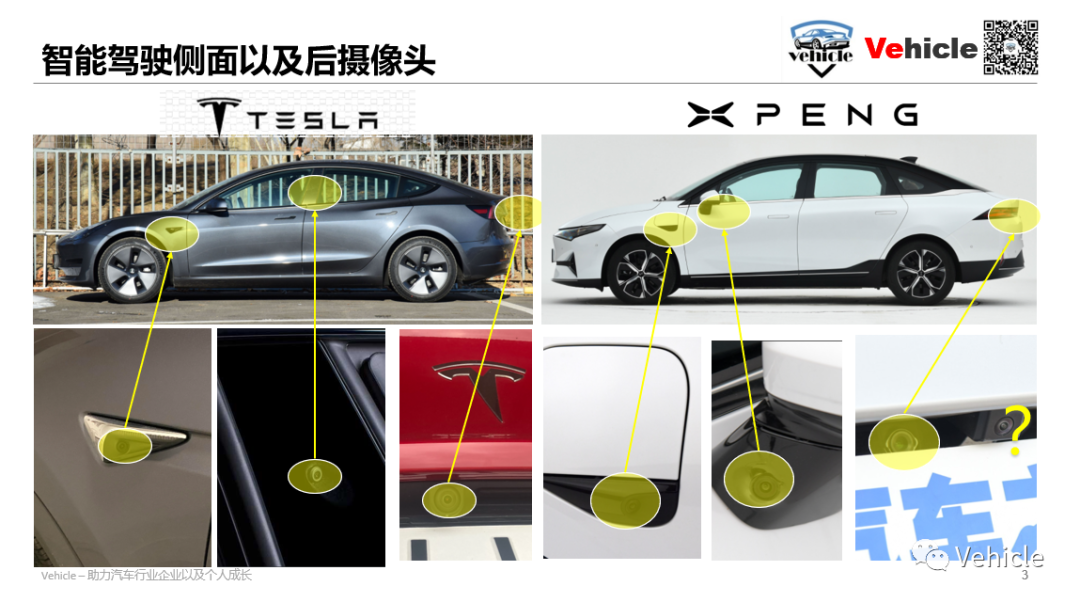

- 前视摄像头, 侧视摄像头,后视镜摄像头,这种配置基本就是当前智能驾驶用于捕获环境的摄像头,前视一般三个,按照检测距离远,中,近三个摄像头;侧视的话一般一边两个前后方向各一个;后视用来拍摄后部环境,他们的设计原则就是确保行车时车辆环境360度无死角捕捉到,行车方向看的越远越好。

- 驾驶舱内摄像头,布置在驾驶舱内用于监控驾驶舱内情况,如我们之前文章智能座舱系列文一,他到底是什么?中介绍用于监控驾驶员情况以及拓展未来更多的智能座舱功能例如驾驶员身份识别。

小鹏汽车的传感器从P7-P5有变化,其实小鹏G3到P7再到P5,小鹏的传感器都有一定的变化,当然主要是针对高配的车辆。特斯拉的传感器比较固定而且中高低配都鲜有变化主要体现其真的基于软件赚钱的想法。

环视摄像头,首先特斯拉是没有泊车辅助的环视摄像头的,它借用其他摄像头来帮助呈现后视等,而国人喜欢搞环视也借助环视搞搞创新。这里我们就可以想到我们媒体老师咔咔一顿测自动泊车发现小鹏以及很多自主品牌车辆都能够停旁边空旷的停车位,而我们智能特斯拉只能用超声波传感器方案停有车在旁边的车位,当然听说特斯拉在测试靠视觉找车位了。

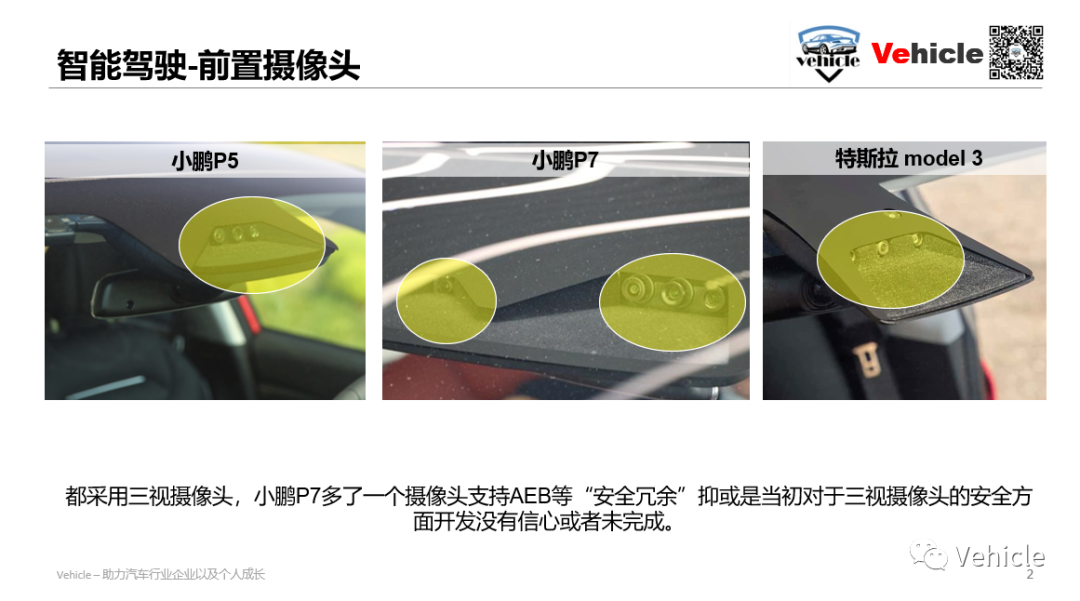

正前方的摄像头,小鹏P7的摄像头为4个,P5为3个,有消息称都为2M像素,而特斯拉同样前置摄像头3个,总共8个摄像头,根据system plus的信息它们基于安森美半导体在 2015 年发布的相同的 1.2 M像素图像传感器。它们既不是新的也不是高分辨率的,价格低廉,所以特斯拉真心是想多赚硬件的钱。

为什么小鹏P7为四个前置摄像头,而到了P5却是3个,其实很明显P7上多的可能就是基于mobileye来实现AEB等功能的摄像头模块,可能P7当时自己的三摄开发没有信息,到了P5可能解决了取消了,省钱了。

小鹏前置摄像头2M像素,帧率15/60fps,按HFOV(Horizon Field of View)分为:

-

HFOV 28:窄视角的前向摄像头,用于AEB(自动紧急刹车)、ACC(自适应巡航)和前向碰撞预警,按图来看,这个摄像头可用于关注150m以上的路面情况;可能是1828*948的分辨率,15fps,用于远距离的感知;

-

HFOV 52:主前向摄像头,用于交通信号灯检测(会看红绿灯)、AEB、ACC、前向碰撞预警和车道感知;

-

HFOV 100:宽视角的前向摄像头,用于交通信号灯检测(会看红绿灯、应该是辅助主前向摄像头的)、雨量检测(自动雨刮要靠它)和防加塞(看的角度更广),猜测应该是60fps的摄像头

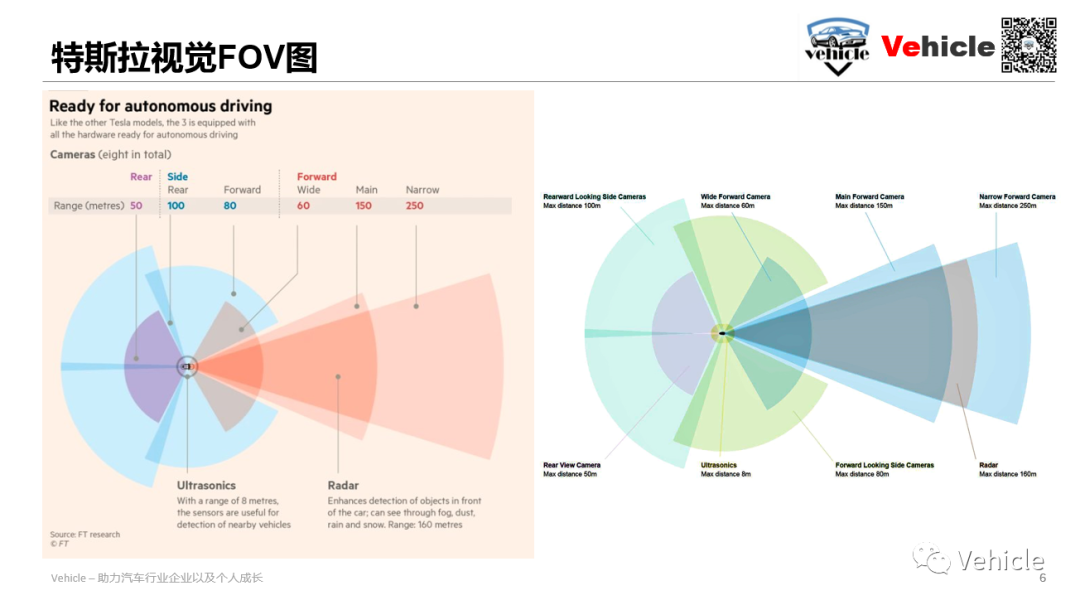

特斯拉前置摄像头分辨率为 1280×960 1.2Mp。它提供了一个长达 250 米的前方图像捕捉系统

侧向的摄像头,小鹏的分别安装在左右车身,都是HFOV 100,应该都是1M像素,但是侧前方向的摄像头是60fps,侧后方是30fps。这四个摄像头其实已经可用完成360度覆盖了,他们的视场还有一点点的重叠。前视侧边摄像头,用于防加塞和侧向车辆的检测(另一张PPT里直接说就是防加塞摄像头),分辨率457*237,较低的分辨率可用于获得更快的响应速度;后视侧边摄像头,用于ALC(自动变道)、开门预警和盲区检测。

特斯拉在B柱上布置了侧向前视摄像头,侧向后视和小鹏一致。

后向的摄像头,小鹏和特斯拉都在牌照灯位置布置了后视摄像头,小鹏是一个HFOV 52,应该与前向的主摄像头一致,2M像素,帧率30fps,用于ALC、盲区检测和追尾预警。

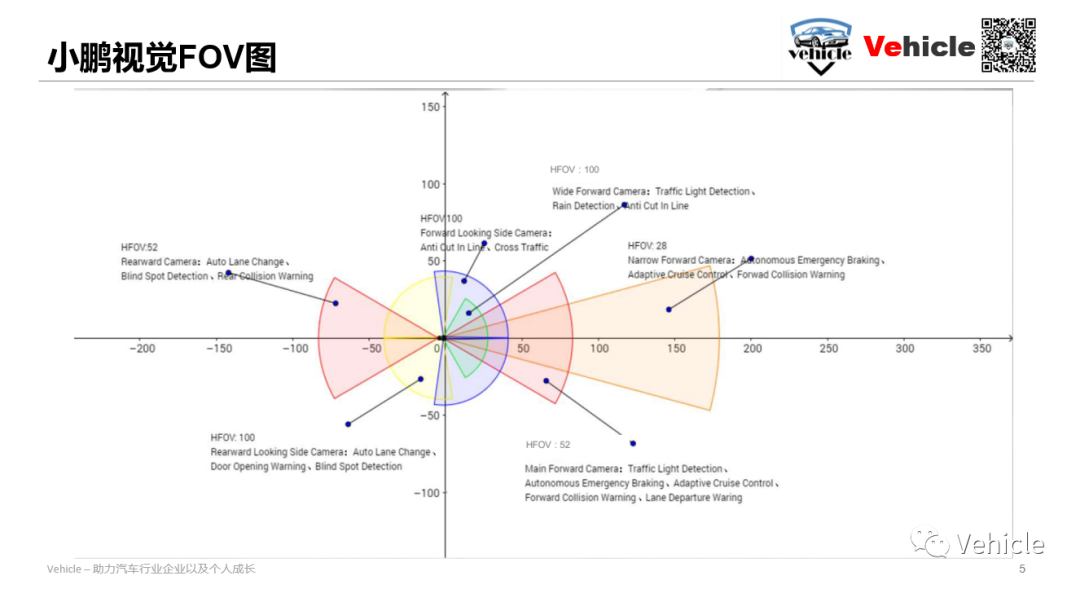

视觉方案对于环境感知的目的是360度覆盖,同时注意侧重点,例如前视显然需要长距离。下面为小鹏和特斯拉视觉FOV图。

特斯拉和小鹏的前视FOV基本一样,抛开视觉距离不一样,当然从图上看特斯拉的前视要远些,但向后的视觉FOV有些差异,可能为两家的方案差异点。

小鹏的尾部摄像头视线长,但窄,而特斯拉采用两个侧向摄像头覆盖后视场景,而尾部摄像头视线短,但宽。这里可以看出特斯拉的尾部摄像头主要是用作倒车或者泊车影像,而小鹏完全不用管,因为它有另外一套泊车环视摄像头。

但总的来讲视觉360度覆盖就为汽车自动驾驶AI 视觉处理提供了基础。

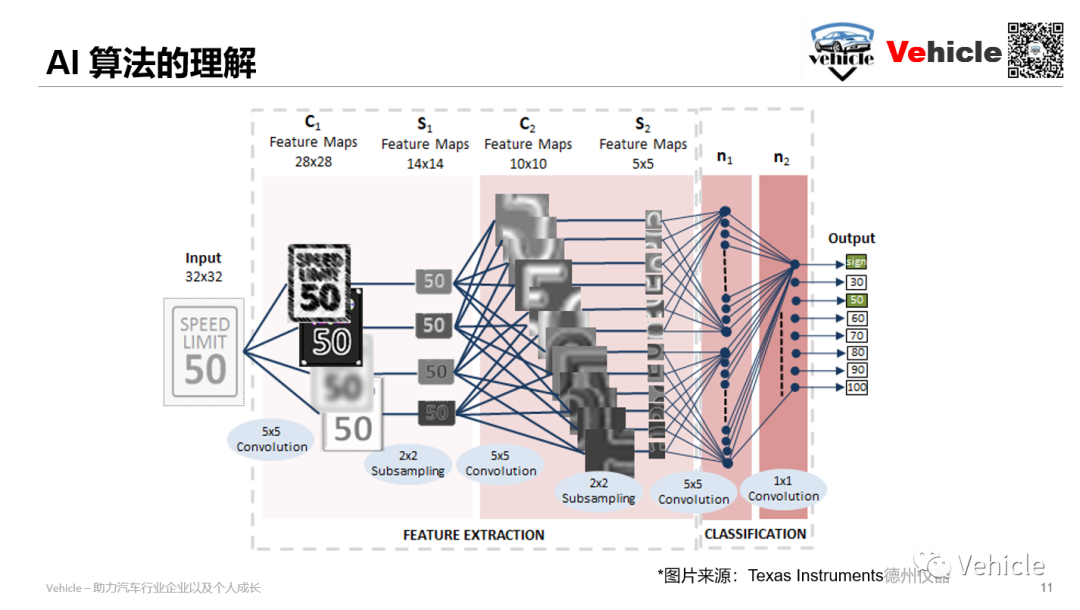

视觉主导,肯定是基于摄像头的图片处理软件技术,当前的AI算法主要一个重要的应用就是目标物识别,行为预测。拿特斯拉来讲其采用CNN用来识别目标,RNN用来不断根据运动学状态以及感知结果更新这个地图和环境,带有时域特征。这两个词听起来挺高深哈,但是其实也不是什么新技术,我们手机里面都用过。

CNN 提取特征信息-例如识别人脸然后戴上各种装饰,他第一步需要识别你的人头在哪里,你的头,鼻子然后确定好了位置才能进行各种装饰,自动驾驶中同样用来识别路面上车辆,行人,自行车,路牌等等。

RNN-具有一种自然的方式来获取图像(即视频)的时间序列并产生最先进的时间预测结果,所以他可以利用上下文信息来预测未来运动例如我们常用的静态动图。(不好意思,对于RNN 应用在静态动图上Pirate Jack没有十足的把握,但好像在哪里看过,如果有真行家欢迎指正)。

那么怎么去理解这个AI算法呢?卷积神经网络 – CNN 解决的第一个问题就是“将复杂问题简化”,把大量参数降维成少量参数,再做处理。

他能够有效的将大数据量的图片降维成小数据量,有效的保留图片特征,符合图片处理的原则,更重要的是:我们在大部分场景下,降维并不会影响结果。比如1000像素的图片缩小成200像素,并不影响肉眼认出来图片中是一只猫还是一只狗,机器也是如此。

其实AI算法之类并不是什么最新的东西,建议读下深度学习三巨头之一 卷积神经网络之父杨立昆的《科学之路》,AI 算法发展坎坷,其实几十年之前就在研究和商用,中途几经周折发展缓慢。

到了现在AI 这么火主要得益于当前互联网大数据的积累,所以可想而知未来AI技术,对于数据的重要性,对于网络安全的重要性。

而当前算法主要是应用层面,所以各家都在宣称自己算法的时候,其实本质没有多大的变化,主要是基于自己数据进行训练模型不同,另外一点是传感器的融合,目前鲜有前融合的方案,前融合就是把所有的以上讲到的传感器信息先集合统一处理,当前主要采用后融合,例如视觉处理输出结论,雷达输出结论,激光雷达输出结论,然后根据各个传感器的优缺点进行不同的权重处理。这种方式说的好一点就是冗余。

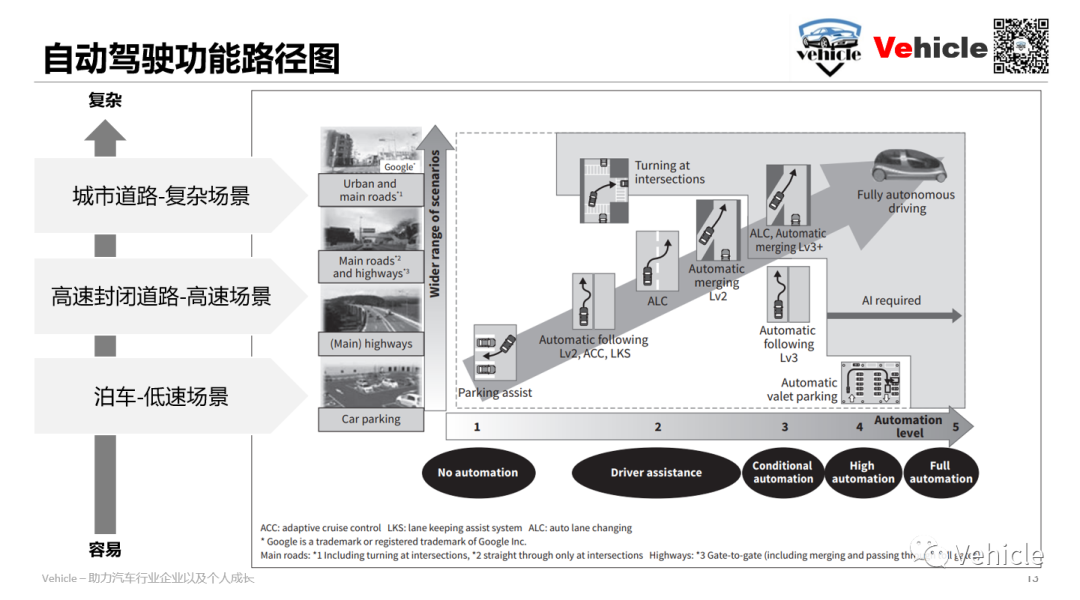

自动驾驶功能,根据容易程度可以划分为应对三种场景的功能,然后各家不论分的多细,其实都是基于这些场景的微分类和拓展。

低速场景-泊车,当前最原始的泊车主要依赖超声波传感器,目前都在利用基于鱼眼摄像头为主导的视觉融合方案,寻找车位和辅助泊车,而小鹏利用前置摄像头的Visual simultaneous localization and mapping (SLAM) 大多数视觉 SLAM 系统的工作方式是通过连续的相机帧跟踪设定点以三角测量它们的 3D 位置,同时使用这些信息来近似相机姿态。基本上,这些系统的目标是为了导航的目的,将他们的周围环境与他们自己的位置相关联。

高速场景-高速或者高架等封闭道路巡航。这一块也是当前拓展相对成熟的行业,主要基于高精地图实施自动进出匝道,以及在封闭道路进行巡航。例如我们之前讲到的(自动驾驶的先启之地-物流运输行业)中图森等都在发力的部分。

这部分主要是规避了,一些复杂的交通参与者,和封闭港口,矿山场景类似。

城市道路-复杂场景。大家可以看每家自动驾驶的规划,最终的难点都在这一块,这里主要是城市道路,情况复杂拥挤而且速度中等,高速都有所覆盖。最大的难点是cut in插车以及各类鬼探头,这就可以理解为什么小鹏P5以及G9在前保左右各装一个激光雷达,其主要就是采用更加准确而且受环境干扰较小的激光雷达来探测前进中可能出现的cut in 以及鬼探头。

本文主要是基于,硬件,软件,功能三块进行视觉自动驾驶方案的宽泛探讨。其实很明确,自动驾驶目前应该形成了以视觉AI 为主导,算力为依托(算力单元点击了解智能自动驾驶六大主流车载芯片及其方案),大数据为基数的一整套工具产业链条。

所以自动驾驶未来的差异点可能还是会回归品牌特征和个性的细微体验差异,而非各种功能。

当然水平有限,权当抛砖引玉,欢迎留言互相学习探讨。

-

Autonomous Driving Technology for Connected Cars - 日立

-

Developing Autonomous Driving EVs for the China Market XPENG Motors’ Approach - 谷俊丽

The original article was posted on the WeChat official account "Smart Car Club."视觉为王-小鹏以及特斯拉的自动驾驶方案